Read more of this story at Slashdot.

In a recent video, YouTuber and photographer Paul Baldonado followed Martha Cooper around NYC's Alphabet City for his Walkie Talkie series, a casual interview series with influential street photographers. Martha Cooper is a legend in the world of street photography, with a career spanning over six decades. Much of her work focuses on New York City, but she has also undertaken numerous global projects and a long-term series in Baltimore. Above all, Cooper is best known for her pioneering work capturing graffiti. Her iconic book Subway Art, which was co-authored with Henry Chalfant and is often called the "bible of graffiti," helped legitimize and popularize street art across the world.

In the video, Cooper discusses her prolific career, including where she got her start, various projects she's worked on and how people's reaction to getting their photos taken has changed. She talks about her time working for the New York Post, which sparked her first street art photos, a personal project documenting Alphabet City, a neighborhood in the East Village in New York City. That project involved capturing kids being creative by making toys with whatever scrap they could find in the numerous vacant lots in the area.

Cooper explains that her graffiti work came from photographing a boy with his pigeon coop, who she had worked with numerous times already. He showed her his notebook of sketches, explaining that he was practicing writing his name on walls, and suggested she take photos of graffiti. That boy introduced her to Dondi, a graffiti king. "After I met Dondi, I became kind of obsessed with graffiti and began a whole other project about that," explains Cooper.

The video touches on other projects, including her Casita series and SOWEBO, which she spent a decade working on. She discusses with Baldonado how you know when a series is done and the struggles of being a photographer. She mentions how hard it has been to get certain bodies of work published, with plenty never seeing the light of day. "If you're going to be a photographer, you really need to learn how to accept rejection," Cooper says.

Cooper is currently working on archiving her extensive library of work and getting her images into the Library of Congress. She's still active on social media, sharing her images of graffiti on Instagram.

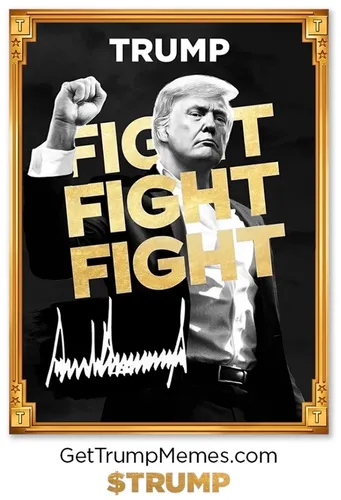

In what is likely a preview of the levels of grift about to come — levels previously not thought possible — Trump has launched a Solana memecoin two days before his inauguration. The move was so unexpected that many believed the president-elect's Twitter account had been compromised to promote a fake scam token, but half a day later, it appears this scam token is of the genuinely Trump-backed variety.

Can't reach someone's private server on localhost from outside? No problem

A years-old security oversight has been addressed in basically all web browsers – Chromium-based browsers, including Microsoft Edge and Google Chrome, WebKit browsers like Apple's Safari, and Mozilla's Firefox.…

Just disabling Siri requires visits to five submenus

A study has concluded that Apple's privacy practices aren't particularly effective, because default apps on the iPhone and Mac have limited privacy settings and confusing configuration options.…